1. 새로운 경험 AI

AI가 나온지 얼마 안된 것 같은데, 생각보다 일상속에 AI가 깊숙하게 자리를 잡은 것 같다.

이전에는 검색을 통해 여러 사람들의 경험과 결과들로 내 정보를 채웠다면

지금은 AI에게 질문하고 AI가 나에게 맞춰 답변해준 내용들로 내 정보를 채우는 것 같다.

물론 AI가 답변해준 내용은 검증이 필요하기에 다시 검색을 하지만...

100점 기준으로, 이전에는 0부터 검색을 시작해 나갔지만 지금은 80부터 시작해 나가는 느낌이다.

다만, 이런 AI는 내가 처음 사용했을 당시에는 Chat GPT, Gemini 와 같이 서비스를 하는 웹 사이트에 접속해서 이용을 해야했다.

이렇게 멋진 능력을 가진 AI를 내 PC에서 나만을 위해 사용될 수 있다면 얼마나 좋을까 하고 찾아보니... 방법이 존재했었다!

지금은 AI를 로컬에서 실행시킬 수 있는 방법들이 많아졌지만 내가 처음 알았을때만 해도 ollama가 가장 유명했었다.

ollama가 나에게 처음 안겨준 경험들도 너무 대단했지만, GUI 없이 CMD로 작업을 한다는게 너무 불편하다고 느껴졌다.

웹 GUI를 내 ollama 서버와 연결시켜 사용할 수 있는 방법들도 있었지만... 굳이 이렇게 까지 해야하나 싶어서 다른 툴을 찾아보다 LM Studio를 발견하게 되었다.

2. LM Studio이란?

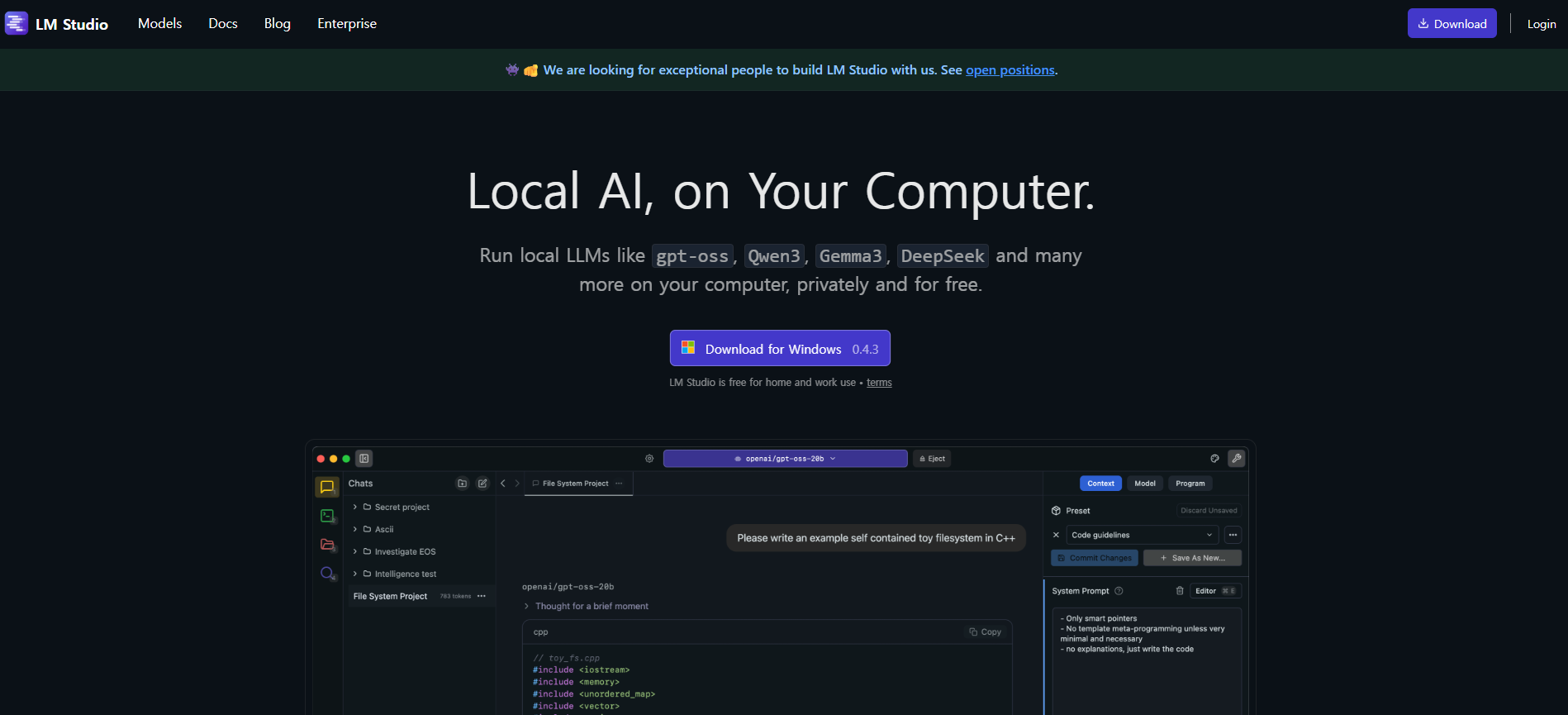

먼저 LM Studio는 뭘까? 하고 찾아보면...

LM Studio는 로컬 환경에서 오픈소스 LLM을 검색, 설치, 실행할 수 있는 올인원 데스크톱 애플리케이션입니다.

가장 큰 특징은 복잡한 설정 없이 GUI(그래픽 사용자 인터페이스)를 통해 모든 과정을 시각적으로 관리할 수 있다는 점입니다.

위에 내용중 내가 정말 흥미를 가지게 해준건 바로 GUI다.

개인적인 생각으로 GUI가 있냐 없냐에 차이로 새로운 것에 적응하는 시간이 달라진다 생각한다.

복잡한 명령어를 내가 익숙해질 때 까지 매번 검색하고 찾고 내 PC에 입력할 필요 없이 GUI를 보면서 실행시키면 얼마나 처음 입장에서는 편하고 좋지 않은가..

물론 이렇게 GUI로 할 수 있는 것들은 자유도에서 보면 많은 제약사항이 생기기도 한다.

하지만 중요한건 내가 로컬 AI를 사용해보는 첫 시작의 경험이다.

서론이 너무 길어 진 것 같다.

이제는 LM Studio를 설치해서 실제 채팅을 하는 것 까지 천천히 진행해보고자 한다.

3. LM Studio 설치부터 채팅까지

먼저 LM Studio(https://lmstudio.ai/)에 접속한다.

처음 사이트에 접속하게 되면 영어들로 꽉찬 홈페이지가 나오지만, 무서워 하지 말자 LM Studio는 한글을 지원해준다.

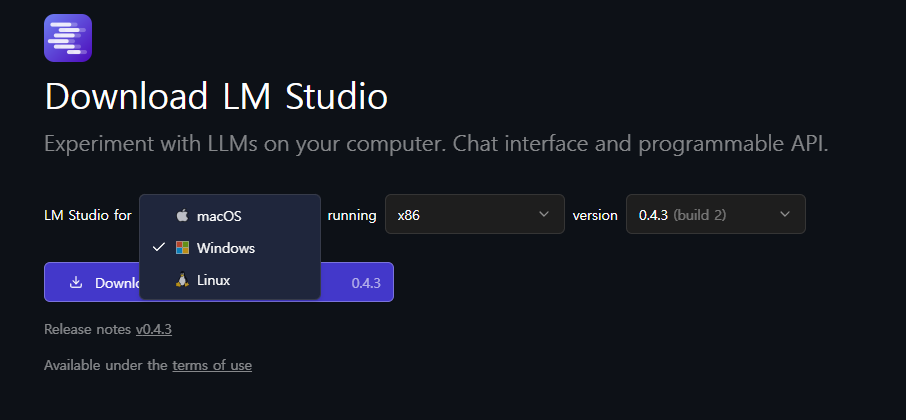

이제 다운로드 버튼을 눌러 설치파일을 다운로드 받는다. ( 참고로 필자의 OS환경은 윈도우11이다. )

LM Studio는 macOS, Linux 다양한 OS를 지원하고 있으니 상단 오른쪽에 있는 다운로드 버튼을 클릭하면 다른 OS에 맞는 파일을 다운로드 받을 수도 있다.

설치화면은 크게 설정해야 할 것이 없어서 별도로 작성하지 않겠다

처음에 LM Studio 화면이 열리게 되면 본인의 PC사양에 맞게 모델을 추천해주면서 다운로드 받으라고 안내해준다

보통 gpt-oss-20b 해당 모델을 안내해주는데 일단 전부 넘어간다

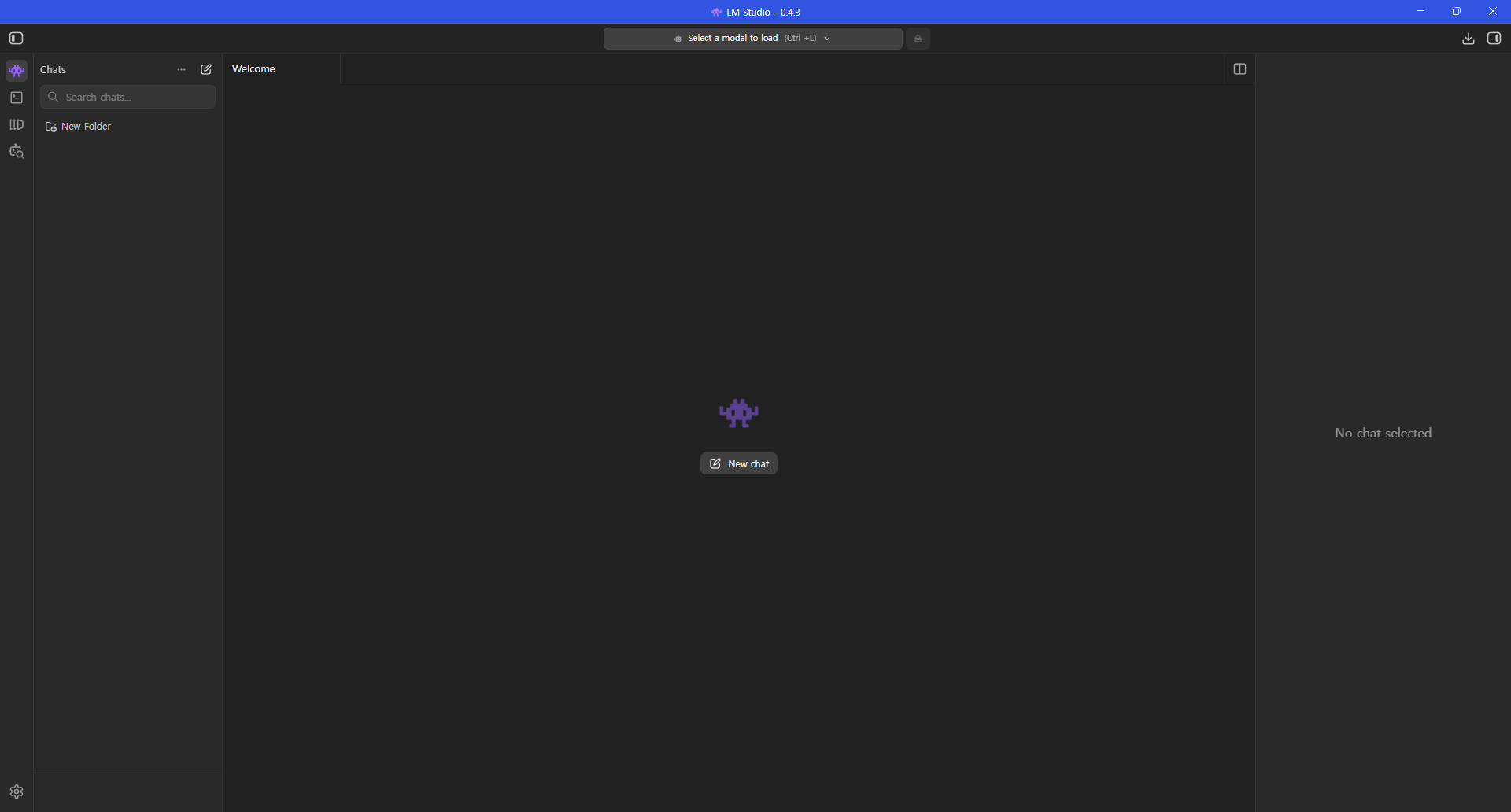

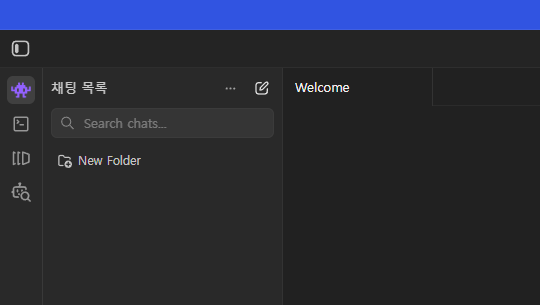

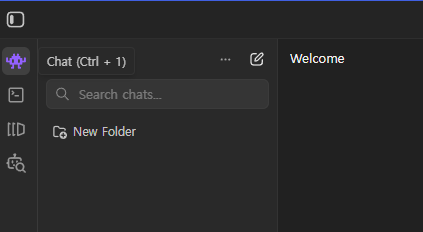

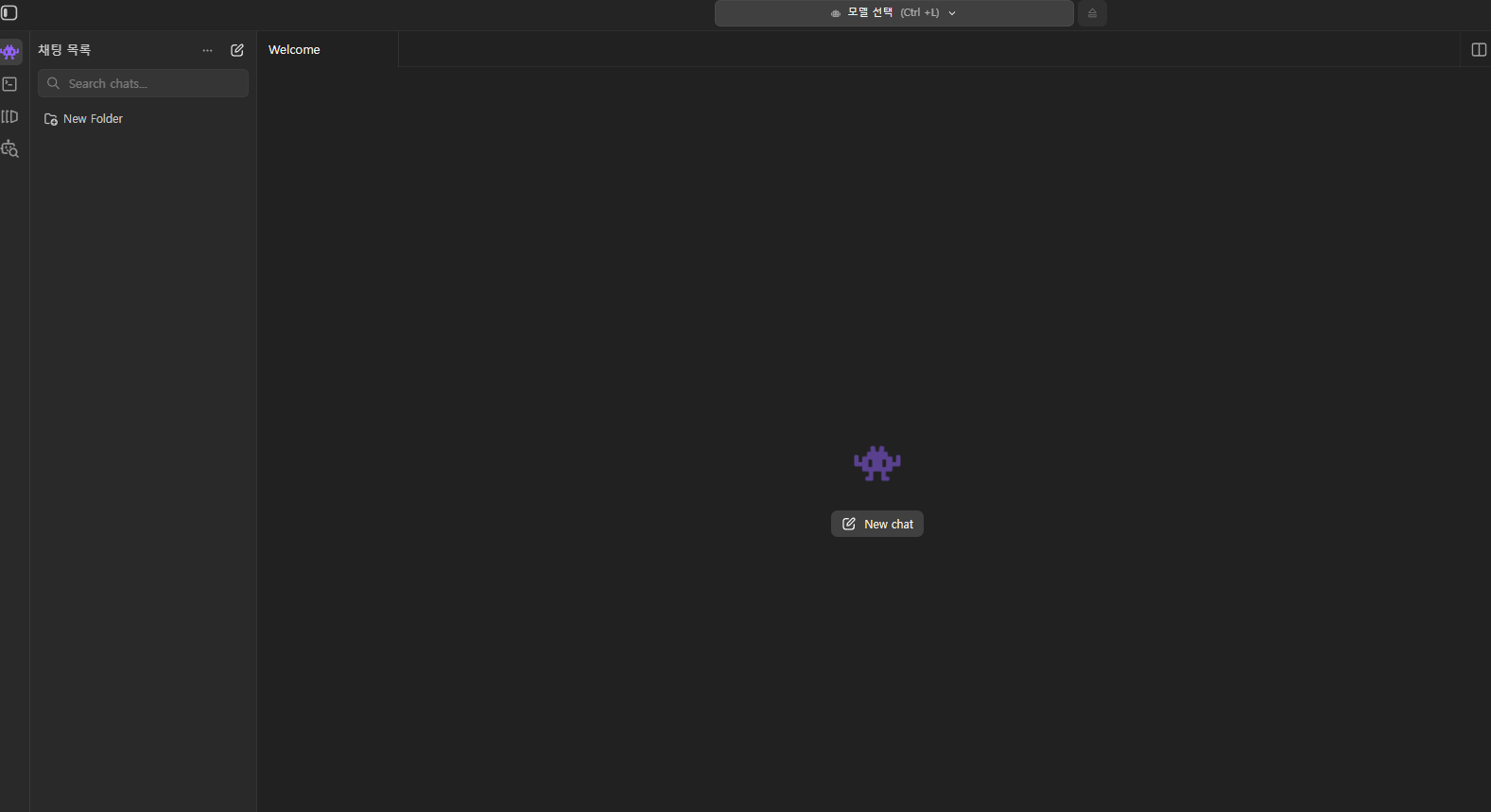

아무런 설정을 하지 않고 메인화면으로 넘어갔다면 아래 이미지와 같은 화면이 나오게 될(?) 것이다.

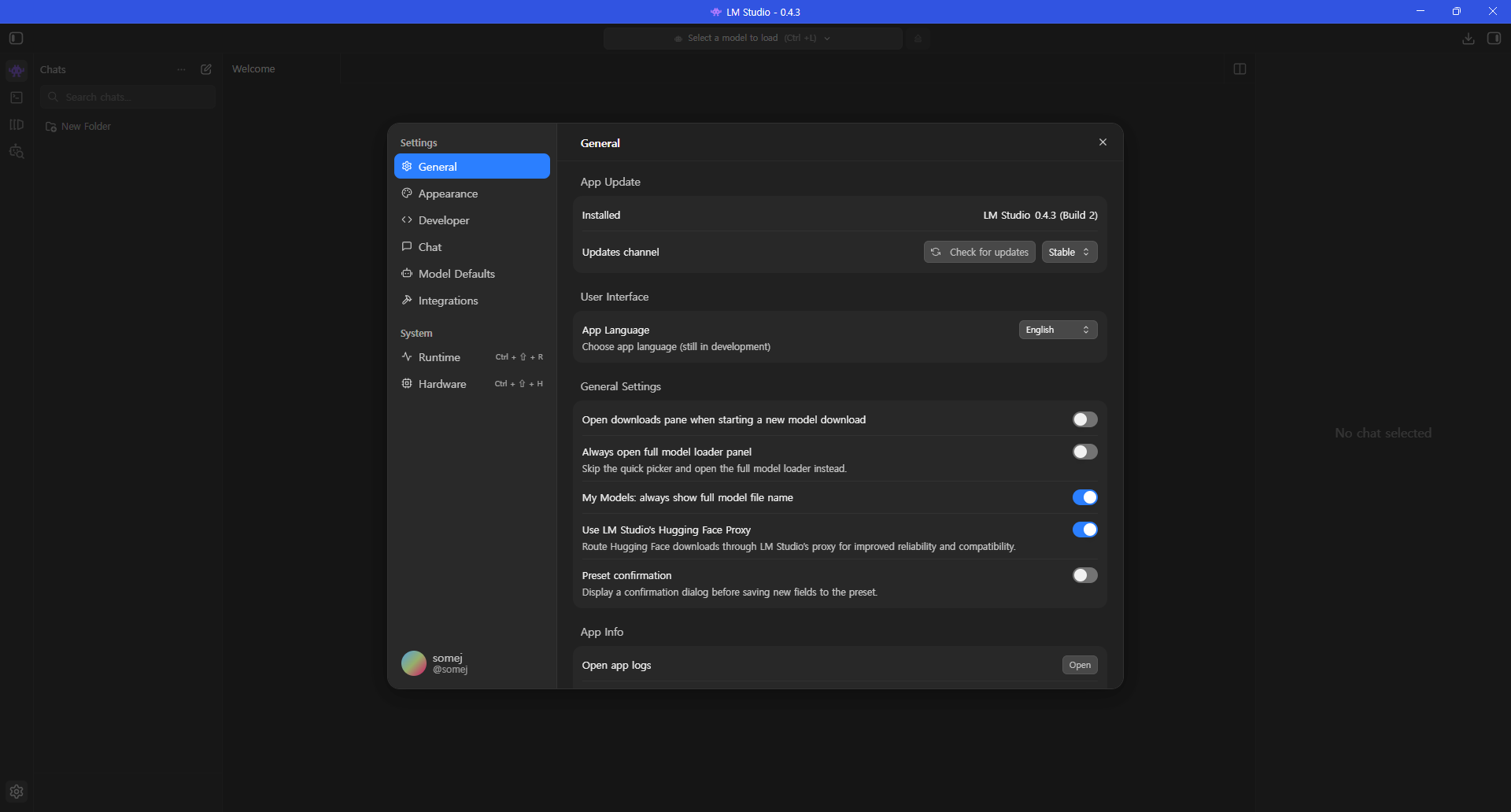

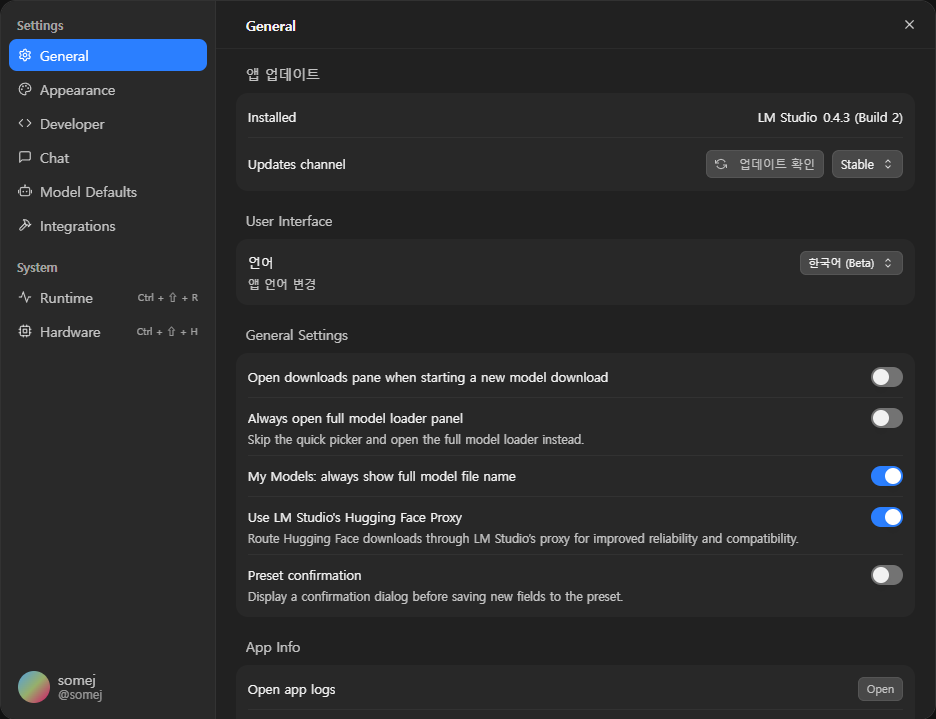

먼저 한글 설정부터 진행하려고 한다.

한글 설정은 아래에 톱니바퀴 모양을 클릭하여 설정에 들어간다.

설정화면 User Interface에 보면 언어를 선택할 수 있는데 클릭해서 한국어(베타)를 선택해주면 설정이 끝난다.

이제 모델을 다운로드 받아서 진행해볼 차례다!

모델에 대해서도 여러가지 할 말들이 많지만 여기에 모든걸 설명하면 길어지니

모든 PC에서 제약없이 실행될 수 있는 모델을 다운로드 받아서 채팅까지 진행하겠다.

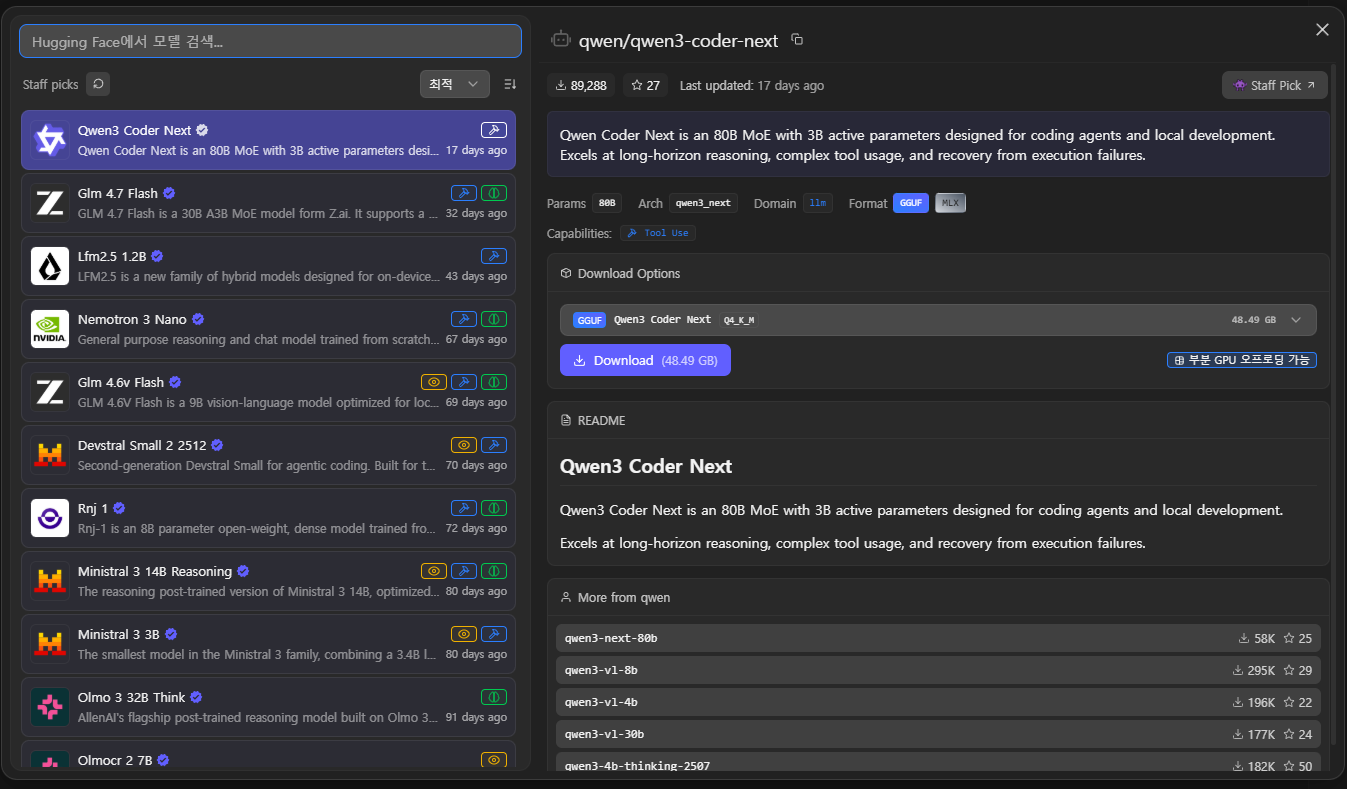

왼쪽 메뉴에 검색 아이콘을 클릭한다.

해당 아이콘을 클릭하게 되면 다운로드 화면이 나오고, 왼쪽에 AI모델 목록이 오른쪽은 선택된 모델에 대한 설명이 나오게 된다.

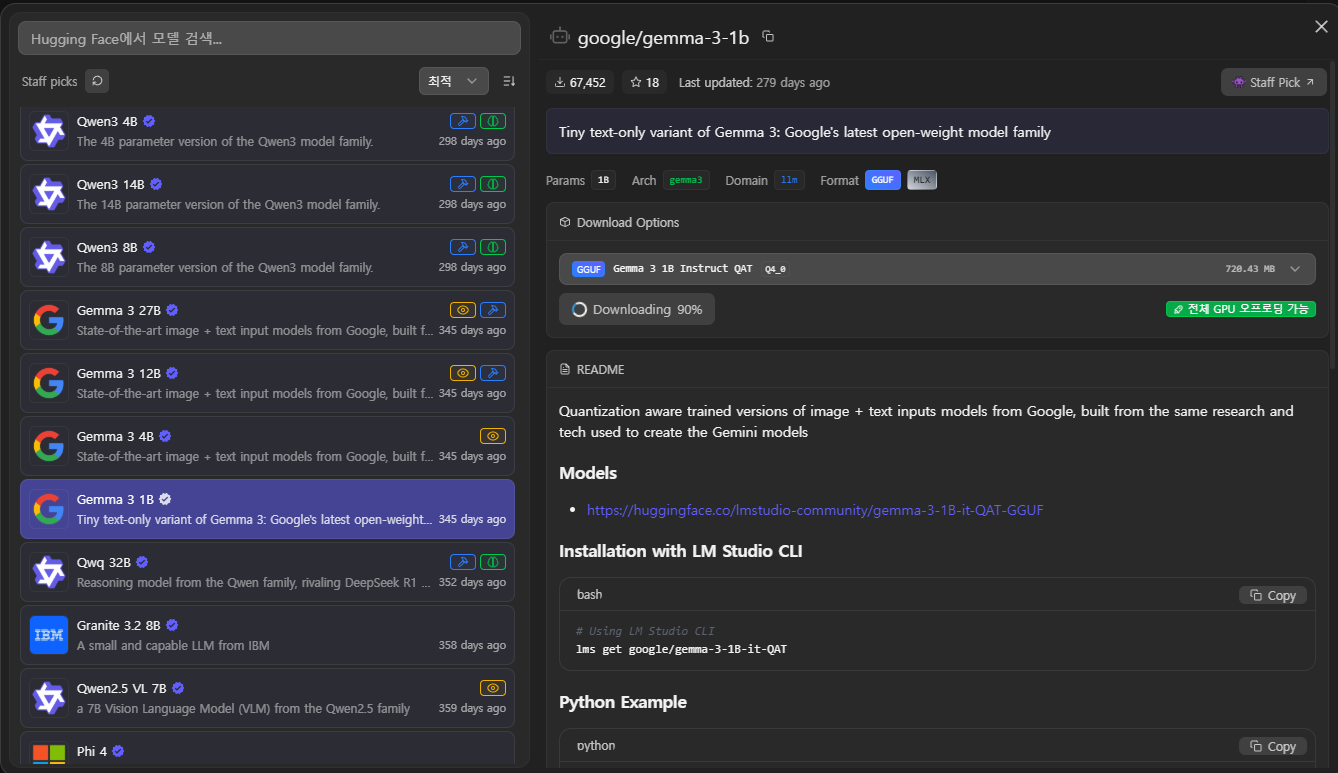

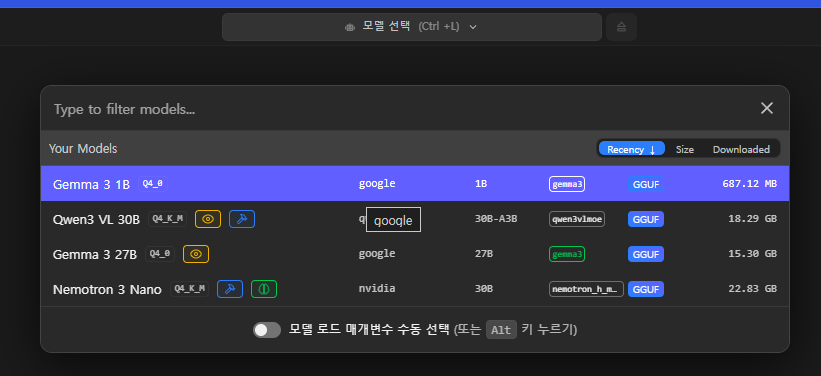

테스트 할 모델은 google에서 만든 gemma-3 1b 모델로 진행하려고 한다.

해당 모델은 성능이 많이 아쉬운 모델이지만 모든 컴퓨터에 무리없이 실행될 수 있는 모델이기도 하다.

이번에는 간단하게 채팅해보는 정도로만 진행하고, 나중에 따로 모델별 성능 관련 글을 작성하도록 하겠다.

그렇게 다운로드를 완료하면 다운로드 창을 닫고 왼쪽 메뉴중 제일 첫번째 아이콘을 클릭하면 채팅으로 이동된다.

채팅 선택이 완료됐다면 화면 중앙에 있는 New Chat을 클릭한다

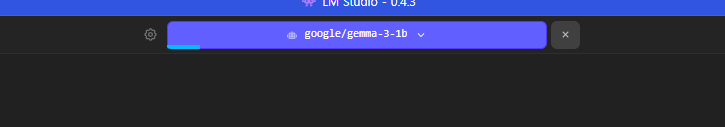

New Chat을 클릭한 이후 상단에 모델 선택을 클릭해서 아까 다운로드 받았던 gemma-3 1b 모델을 선택한다.

해당 모델을 선택하면 진행 표시줄이 보이고 불러오기가 완료됐다면 이제부터 채팅을 시작할 수 있다!

간단한 인사부터 진행해보자

아래 채팅 입력칸에 안녕이라고 입력했다.

그럼 다음과 같이 답변해준다

이렇게 해서 LM Studio를 설치해서 로컬 AI 모델을 다운로드 받고 실제 채팅까지 진행하였다.

아래 몇가지 더 추가 내용을 작성하고 이만 마무리 하겠다.

다음에는 좀 더 자세한 이야기로 돌아오도로 하겠다.

1. 주요 차이점 요약

| 구분 | 로컬 LLM (On-device) | 클라우드 LLM (SaaS/API) |

| 운용 방식 | 개인 PC 또는 사내 서버에서 구동 | OpenAI, Google 등의 서버에서 구동 |

| 데이터 보안 | 최상 (데이터가 외부로 나가지 않음) | 주의 (학습이나 보안 정책에 따라 유출 위험) |

| 비용 | 하드웨어 구매 후 무료 | 사용량만큼 지불 (API 비용/구독료) |

| 성능(지능) | 하드웨어 사양에 따라 제한됨 | 현존 최강의 성능 (GPT-4o, Claude 3.5 등) |

| 인터넷 연결 | 불필요 (오프라인 작동) | 필수 |

2. 장점과 단점 상세 비교

로컬 LLM (예: LM Studio, Ollama)

👍 장점

-

완벽한 프라이버시: 민감한 프로젝트 소스 코드나 개인 정보를 다룰 때 유출 걱정이 전혀 없습니다.

-

지연 시간(Latency) 최소화: 네트워크를 거치지 않으므로 내 하드웨어가 빠르면 즉각적인 반응을 얻을 수 있습니다.

-

무제한 사용: API 호출 횟수 제한이나 토큰당 비용 걱정 없이 24시간 돌릴 수 있습니다.

-

커스터마이징: 시스템 프롬프트, 샘플링 파라미터(Temp 등)를 내 입맛대로 정밀하게 조정 가능합니다.

👎 단점

-

초기 하드웨어 비용: 좋은 성능의 모델을 사용하기 위해서 고성능 GPU(RTX 4090/5090 등)가 필수적입니다.

-

모델 크기의 한계: VRAM 용량에 따라 구동 가능한 모델 크기가 제한됩니다. (70B 모델 등은 구동이 무거울 수 있음)

-

직접 관리: 모델 업데이트, 환경 설정 등을 직접 챙겨야 합니다.

클라우드 LLM (예: ChatGPT, Claude, Gemini)

👍 장점

-

압도적인 지능: 조 단위의 파라미터를 가진 거대 모델을 사용하므로 복잡한 논리나 고도의 코딩 문제 해결 능력이 뛰어납니다.

-

편의성: 설치 과정 없이 브라우저나 API 키 하나로 즉시 최신 모델을 사용할 수 있습니다.

-

멀티모달 기능: 이미지 생성, 파일 분석, 실시간 음성 대화 등이 매우 매끄럽게 통합되어 있습니다.

👎 단점

-

보안 리스크: '보안 모드'가 있다 해도 데이터가 서버로 전송되므로, 기업용 기밀 데이터를 다루기엔 껄끄럽습니다.

-

누적 비용: 대량의 데이터를 처리할 경우 API 비용이 생각보다 많이 발생할 수 있습니다.

-

서비스 의존성: 서비스 장애가 발생하거나 정책이 바뀌면 업무에 차질이 생깁니다.

댓글 0개